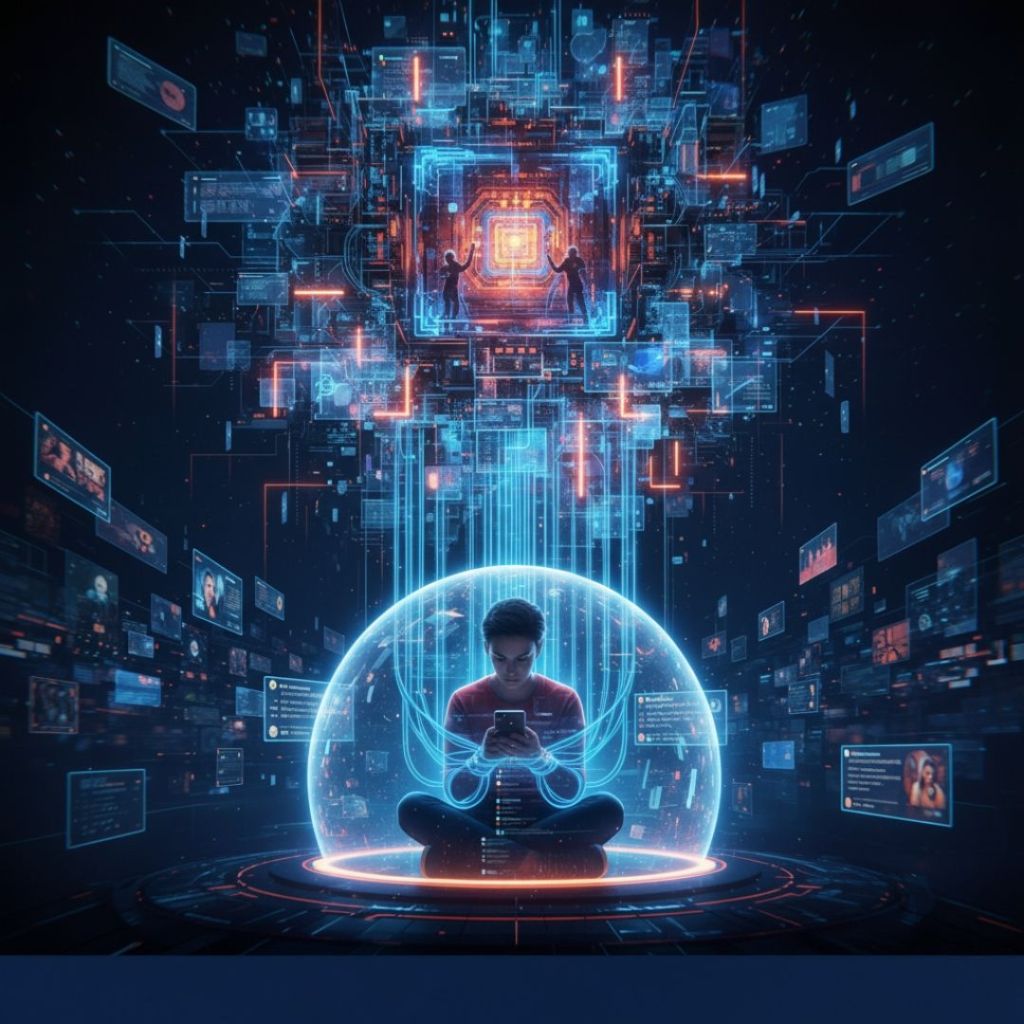

Ogni giorno, scorriamo i vari contenuti dei nostri social network, convinti di esplorare liberi e tranquilli il mondo digitale. Purtroppo dietro ogni post, video o storia che appare sullo schermo, c’è un sofisticato sistema algoritmico che decide cosa mostrare, quando e soprattutto a chi. Questi algoritmi non sono per nulla neutrali, perché progettati per massimizzare l’engagement e il tempo trascorso sulle piattaforme. Per scrivere questo articolo mi sono posto una domanda: fino a che punto questi sistemi stanno influenzando le nostre decisioni, le nostre opinioni e la nostra percezione della realtà?

Come funzionano gli algoritmi dei social media

Gli algoritmi dei social network sono complessi sistemi di intelligenza artificiale, che analizzano un’enorme quantità di dati sugli utenti. Quello che sappiamo è che prendono in considerazione cosa guardiamo, per quanto tempo, cosa commentiamo, condividiamo e anche dove ci fermiamo di più. Questi dati vengono utilizzati per creare profili dettagliati e prevedere quali contenuti cattureranno maggiormente l’attenzione dell’utente. Gli algoritmi hanno capito che i contenuti emotivamente carichi, schierati o controversi generano più interazioni. Un video che suscita molta indignazione viene commentato e condiviso più di uno “neutrale”, ed è cosa certa che un titolo allarmistico attira più click di uno per così dire “informativo”. Gradualmente, il feed si popola di contenuti sempre più estremi, creando quelle che gli esperti chiamano “bolle informative”, dove gli utenti vengono esposti principalmente a contenuti che confermano le loro preesistenti convinzioni. Un vero e proprio meccanismo.

L’influenza sulle scelte individuali e collettive

L’impatto di questi algoritmi va oltre la semplice selezione di quale video guardare. Le piattaforme possono amplificare teorie del complotto talvolta “deliranti”, disinformazione medica e contenuti di natura dannosa. Chiunque faccia una ricerca di contenuti sul fitness potrebbe trovarsi esposto a materiale che promuove disturbi alimentari. Un utente interessato alla politica potrebbe essere radicalizzato attraverso contenuti sempre più estremi, senza nemmeno rendersene conto. Il fenomeno diventa preoccupante quando si tratta di informazioni che influenzano scelte di estrema importanza, come quella elettorale o sanitaria. Gli algoritmi non valutano la veridicità o l’impatto sociale che possono avere alcuni contenuti, ma solo la loro capacità di farci mantenere l’attenzione. Vi lascio un link che ritengo essere molto interessante: https://www.labussoladellia.com/ia-e-social-media-algoritmi-che-ci-guidano/

Le denunce e gli scandali

Il caso più emblematico è quello di Frances Haugen, un ex dipendente di Facebook (ora Meta), che nel 2021 ha rilasciato migliaia di documenti interni all’azienda. Gli ormai famosi “Facebook Files” hanno rivelato che la compagnia era pienamente consapevole degli effetti dannosi dei loro algoritmi. Documenti interni mostravano che Instagram sapeva che la piattaforma incrementava i problemi di immagine corporea in una ragazza su tre, contribuendo a depressione e ansia. Nonostante questa consapevolezza, l’azienda ha continuato a ottimizzare l’algoritmo per massimizzare il coinvolgimento, se volete un linguaggio più tecnico possiamo chiamarlo anche engagement.

Haugen ha testimoniato davanti al Congresso degli Stati Uniti, affermando che Facebook “mette prima i profitti della sicurezza” e che i suoi algoritmi “dividono le persone, danneggiano i bambini e indeboliscono la democrazia”. Le sue rivelazioni hanno fatto scattare indagini in tutto il mondo.

Nel 2023, oltre quaranta stati americani hanno intentato una causa collettiva contro Meta, accusando l’azienda di aver deliberatamente progettato funzionalità per attrarre e trattenere giovani utenti, causando una crisi di salute mentale tra gli adolescenti. Le accuse includono l’uso di notifiche progettate per creare dipendenza, l’aggiunta di funzionalità come lo “scroll infinito” e la raccolta illegale di dati da minori di 13 anni.

Anche TikTok è stato al centro di diverse controversie. Nel 2022, diversi whistleblower hanno rivelato che l’algoritmo della piattaforma può rapidamente intrappolare utenti, specialmente giovani, in “tunnel” di contenuti potenzialmente dannosi. Un’inchiesta del Wall Street Journal ha dimostrato come account di test creati per sembrare adolescenti venissero rapidamente esposti a contenuti relativi a disturbi alimentari, autolesionismo e suicidio, dopo aver mostrato anche solo un minimo interesse per questi temi. Se non avete idea di cosa sia un whistleblower vi allego la spiegazione di Wikipedia: https://it.wikipedia.org/wiki/Whistleblower

YouTube ha affrontato critiche simili. Nel 2019, un’indagine ha rivelato che l’algoritmo della piattaforma tendeva a portare gli utenti verso contenuti sempre più estremisti, un fenomeno documentato questa volta da Guillaume Chaslot, ex ingegnere di YouTube, e fondatore dell’organizzazione AlgoTransparency per studiare questi meccanismi.

Nel 2021, l’Unione Europea ha presentato il Digital Services Act, una legislazione innovativa che richiede maggiore trasparenza algoritmica e responsabilità delle piattaforme per i contenuti dannosi. Leggi simili sono in discussione molti paesi, mentre class action e indagini si moltiplicano.

Tiriamo le somme

Di fronte a questo lasciatemi dire “triste” panorama, è facile sentirsi impotenti, e la consapevolezza è il primo passo verso il cambiamento. Comprendere che ciò che vediamo online non è neutrale, e che ogni contenuto mostrato, è selezionato con precisione per aumentare il nostro coinvolgimento, ci permette di sviluppare un approccio più critico e soprattutto più consapevole.

Non si tratta di demonizzare la tecnologia o i social network, che hanno portato comunque, anche diversi benefici come: aver connesso le persone, dato voce a comunità più marginalizzate, aiutato movimenti sociali e permesso varie forme di creatività ed espressione che non si erano mai viste prima. Si tratta invece di riconoscere che questi strumenti, così come sono attualmente programmati, hanno un “costo” che paghiamo in termini di benessere mentale e sociale.

Come individui, possiamo fare scelte più consapevoli: limitare il tempo sui social, diversificare sempre le fonti di informazione, cercare punti di vista differenti. Il mio consiglio (che ormai da tempo applico) è di disattivare le notifiche che ci riportano costantemente sulle varie piattaforme. È importante però anche capire che la responsabilità non può ricadere solo sugli utenti, e serve un impegno collettivo per chiedere che queste piattaforme siano progettate con l’interesse pubblico al centro di tutto. Serve quindi una regolamentazione forte, chiara e trasparente.

Viviamo in un momento dove stiamo ancora imparando a convivere con tecnologie che hanno trasformato radicalmente il modo in cui comunichiamo, e soprattutto quello con cui ci informiamo e cerchiamo di comprendere un mondo sempre più complesso. Gli errori ci sono stati, i danni sono reali, ma non siamo impotenti come pensiamo. Ogni volta che scegliamo “consapevolmente” di interagire con queste piattaforme e ogni volta che chiediamo maggiore responsabilità di utilizzo, stiamo contribuendo al miglioramento del futuro digitale.

La sfida è decisamente grande, ma merita tutto il nostro impegno, per noi stessi, e soprattutto per le generazioni future, che erediteranno il mondo digitale che stiamo contribuendo a creare oggi.

Luca Muzi

Castel Viscardo 📍

Scrivi una risposta a guido arci camalli Cancella risposta